Erstellung von realistischem Video Content mithilfe von Künstlicher Intelligenz

Eine Revolution in der Content Creation?

von Peter Hicks

22.03.2024

Wir bei dmcgroup starteten ein Experiment und wollten die Grenzen von Künstlicher Intelligenz austesten. 2023 veranstalteten wir einen Workshop in Düsseldorf, bei dem wir herausfinden wollten, wie wir die Macht der KI für unser Unternehmen nutzen und sie mit unserer Kreativität verschmelzen können. Wir wollen dadurch unsere Fähigkeiten verbessern und so außergewöhnliche Lösungen für unsere Kunden schaffen. Wir kehrten mit großer Faszination nach Wien zurück und starteten voller Tatendrang ein neues KI Projekt: Die Fusion unserer Standorte war über die vergangenen Monate hinweg ein zentrales Thema für uns. Um diese Zusammenführung der Standorte zu veranschaulichen, wollten wir mit der Unterstützung von KI, ein Video erstellen.

Und die Reise beginnt

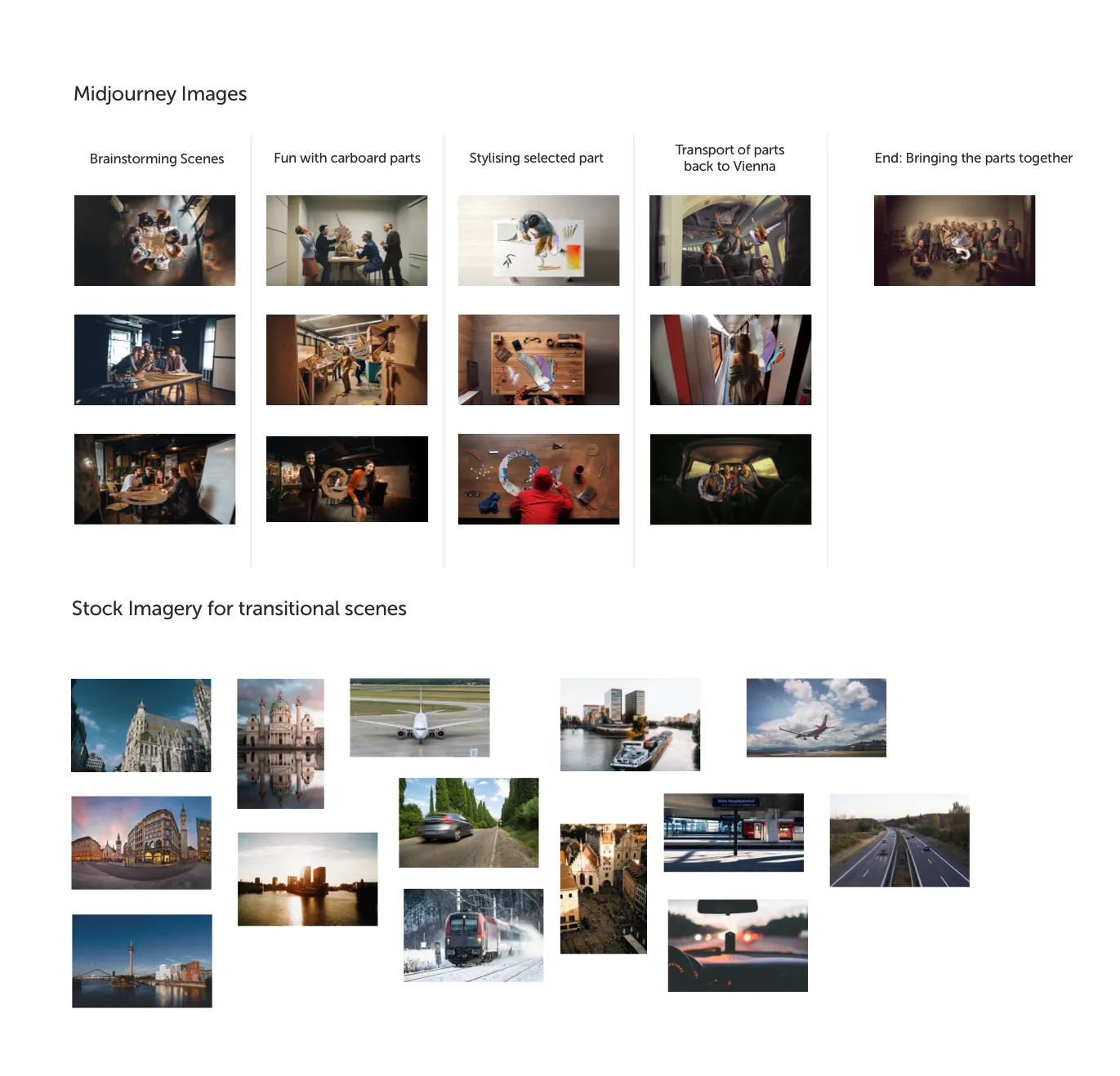

Ich startete mit der Erstellung eines Storyboards, das für mich als Grundlage für das Video diente. Mittelpunkt der Geschichte sollte, wie oben erwähnt, die Fusion der dmcgroup Standorte sein. Zu Beginn gestaltet jeder Standort von dmcgroup ein bestimmtes Körperteil des dmcgroup Beasts. Begleitet vom Beatles-Song “Coming Together” soll sich danach jeder Standort auf den Weg zurück zur dmcgroup Zentrale nach Wien machen und hier ihr Kunstwerk präsentieren. In einer dramatischen Transformation sollen sich diese Teile dann zusammenfügen und das dmcgroup-Logo entsteht.

Ursprünglich war dies als reines Videoprojekt gedacht, das ich auf der Weihnachtsfeier präsentieren sollte. Jeder Standort sollte die Gestaltung der Körperteile und die Anreise nach Wien selbst dokumentieren. Das große Finale sollte dann auf der Party stattfinden, wo alle Teile des Beasts zusammengeführt werden.

Es hat sich hier aber eine einzigartige Gelegenheit geboten, die Grenzen der Innovation auszutesten. Ich stellte mich der Herausforderung, das Storyboards allein von Künstlicher Intelligenz schreiben zu lassen.

Prompten, Prompten und noch mehr Prompten

Die Magie der generativen KI liegt in der Macht des Promptens. Man “beschwört” den KI-Genie mit seinen Wünschen, reibt an der Lampe, und mehrere Optionen erscheinen einem und alle Wünsche werden erfüllt. Diese Methode erweist sich bei KI nur dann als effektiv, wenn die Idee, die man hat, nur vage ist. Wenn es sich jedoch um etwas sehr Spezielles handelt – z. B. eine Bleistiftskizze einer besonderen Szene – wird der Prozess komplizierter, kostspieliger und wahrscheinlich auch ärgerlich.

An der Spitze der KI-Bilderzeugung steht Midjourney, eine führende Plattform, die für ihre scheinbar bahnbrechenden Funktionen bekannt ist. Über die Chat-Anwendung Discord können die Nutzer:innen prompten und erhalten im Gegenzug hyper-realistische Bilder. Die Länge der Bearbeitungszeit und die Begrenzung der Warteschlangen hängt aber vom jeweilig abgeschlossenem Abonnement ab.

Jeder Prompt dauert dementsprechend. “Zeig mir ein Bild von einem Frosch!” Das ist CPU-Time. “Jetzt mach den Frosch grün.” Noch mehr CPU-Time. “Gib dem grünen Frosch schwarze Flecken.” Richtig geraten – noch mehr CPU-Time!

Die Trail and Error Methode der generativen KI ist solange schön und gut, bis man mal nicht so viel Zeit zur Verfügung hat.

Wenn man eine sehr spezifische Vision von einem Visual im Kopf hat, gibt man sich mit vagen Ergebnissen oft nicht zufrieden. Man kommt in ein Rad, in dem man bestimmte Elemente erneut promptet, das beibehält, was einem gefällt, und die Bereiche verfeinert, die angepasst werden müssen. Dennoch gibt es Fälle, in denen Midjourney das Ziel völlig zu verfehlen scheint. Midjourney ist für seine Missinterpretation von Händen bekannt geworden. Gelegentlich fügt es eine, zwei oder mehrere Komponenten hinzu, was oftmals zu Ergebnissen führt, die ziemlich befremdlich wirken können.

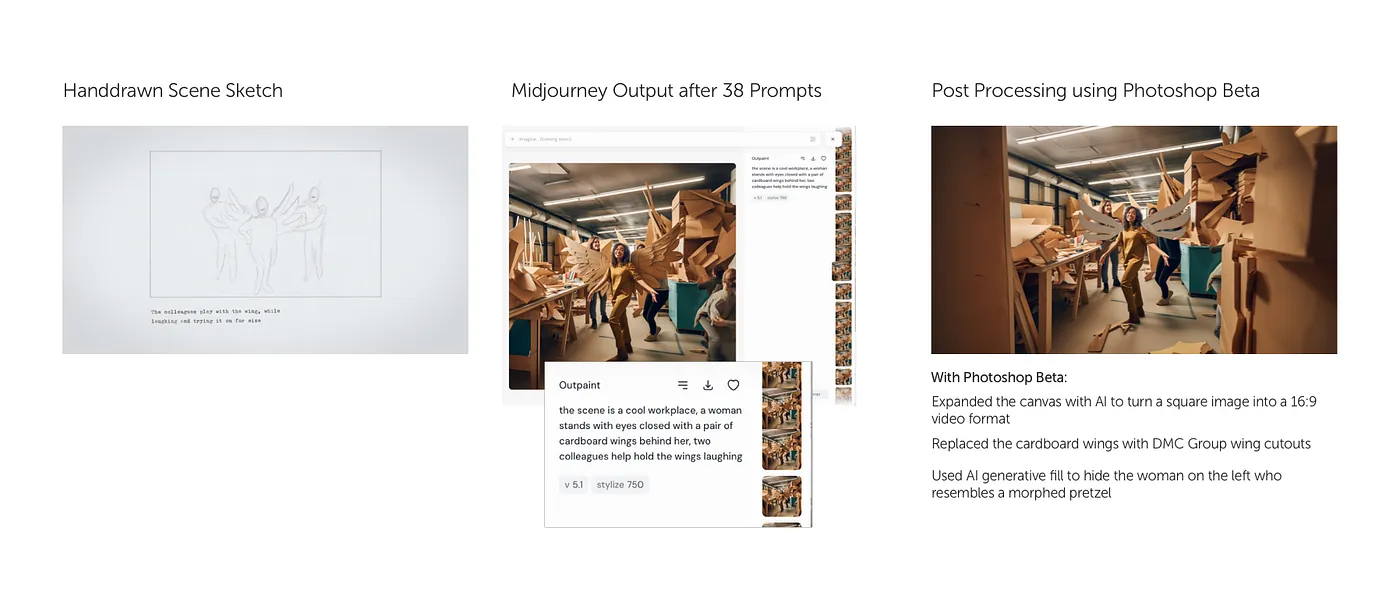

Nachdem ich mit den Fehlern von Midjourney zu kämpfen hatte und nicht in einem endlosen Rad von Prompting feststecken wollte, habe ich beschlossen, die Dinge selbst in die Hand zu nehmen, und zwar im wahrsten Sinne des Wortes. Ich erstellte das generierte Bild in Photoshop Beta und versuchte, die Details zu verfeinern und zu perfektionieren.

“Bitte erstellen Sie eine normal aussehende Hand.”

Am Ende entwickelte ich dann einen hybriden Ansatz: Ich nutzte Midjourney, um mich dem gewünschten Ergebnis anzunähern, und nahm dann Fine-Tuning der problematischen Bereiche mit der KI von Photoshop vor. Das Ergebnis? Bilder, die den Storyboard-Folien, die ich skizziert hatte, sehr ähnlich waren.

Learn

more

Wir sind sind mehr als nur Expert:innen – Unser engagiertes Team von Designer:innen, Entwickler:innen und Marketingspezialist:innen arbeitet Hand in Hand, um Ihre digitale Präsenz auf das nächste Level zu heben.

Bereit für den nächsten Schritt?

Kontaktieren Sie uns und erfahren Sie mehr über unsere Dienstleistungen.

Statische Bilder animieren: Mit Runway Bilder zum Leben erwecken

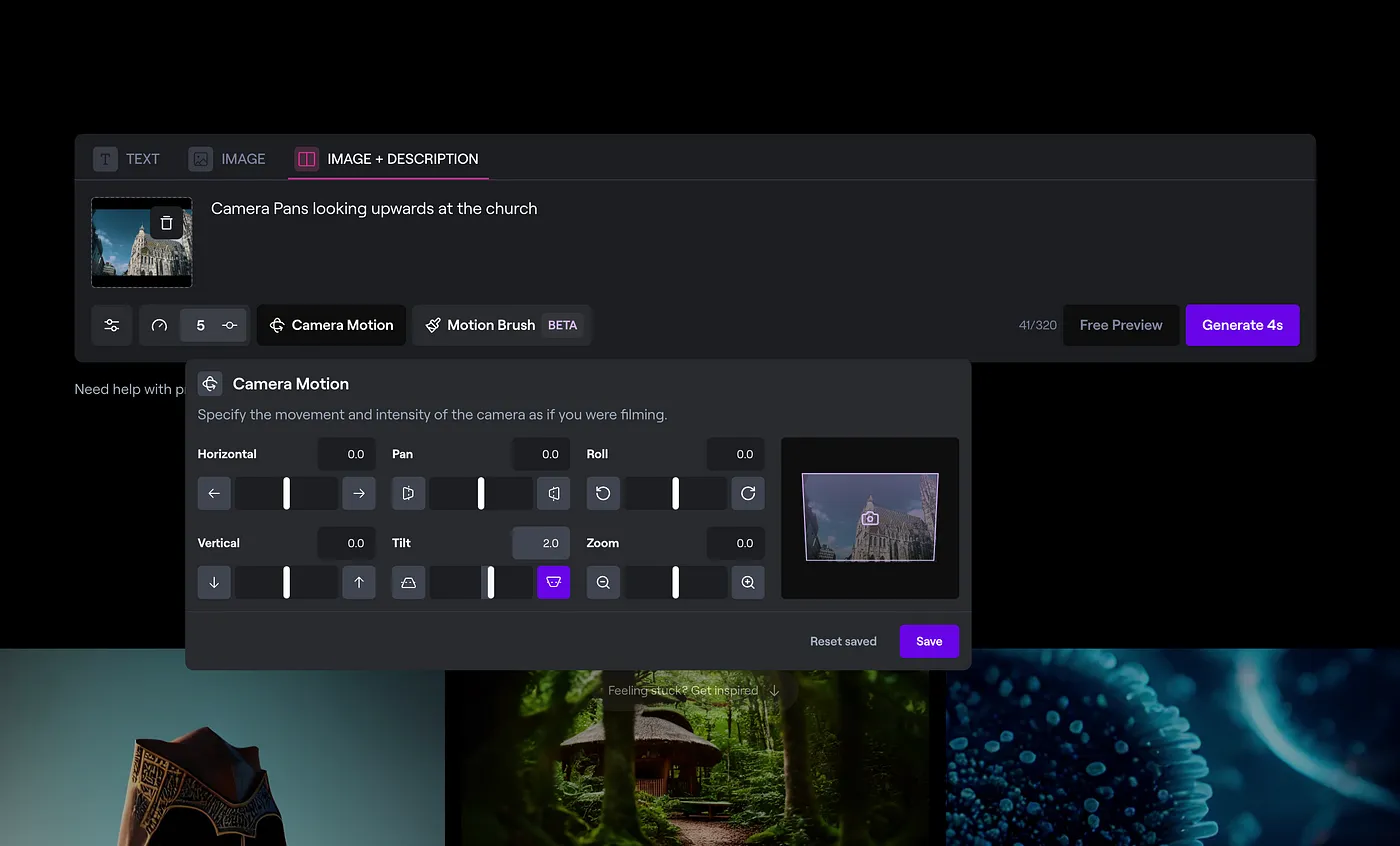

Nach dem Fine-Tuning meiner KI-generierten Bilder wollte ich als Nächstes die Fähigkeit der KI zur Animation statischer Bilder austesten. Eines der bekanntesten KI-Tools, die solche Prozesse erleichtern sollen, ist Runway.

Mit Runway konnte ich meine statischen Szenen hochladen und die KI damit beauftragen, sie mit Bewegung zu versehen. Ich hatte die Möglichkeit, der KI entweder die volle kreative Kontrolle zu überlassen oder spezifische Anweisungen für die gewünschten Ergebnisse zu geben. Außerdem erlaubt Runway den Benutzer:innen, Kamerabewegungen wie Schwenken und Zoomen innerhalb der Szenen zu diktieren.

Ähnlich wie bei Midjourney werden auch für die Verwendung von Prompts GPU-Ressourcen benötigt. Dies hängt vom Abonnement ab, wenn man das monatliche Kontingent überschreitet, müssen zusätzliche Credits erworben werden.

Anfangs habe ich Runway erlaubt, die Bilder selbständig zu interpretieren und zu animieren. Zum Zeitpunkt der Erstellung dieses Artikels kann das Ergebnis von Runway etwas uneinheitlich sein. Bei einfachen Szenen (z. B. ein Gebäude vor einem Himmelshintergrund) leistet Runway hervorragende Arbeit, indem es Wolken und Sonnenlicht animiert und die Kamera sanft schwenkt und zoomt, wodurch ein realistischer Kinoeffekt entsteht.

Als ich jedoch versuchte, spezifische Anweisungen zu geben, stand ich vor ähnlichen Herausforderungen wie bei Midjourney. Entweder hat die Software meine Prompts nicht verstanden, oder ich habe einfach nicht die richtigen Anweisungen formuliert. Dies führte dann dazu, dass einige Szenen unnatürliche, menschliche Bewegungen zeigten oder Gesichter ineinander übergingen, wie in einem Science-Fiction-Horrorfilm.

Ein gutes Beispiel, das einige dieser Herausforderungen veranschaulicht, war der Versuch, eine Szene auf der Autobahn zu erstellen, die meine dmcgroup-Kolleg:innen bei der Fahrt mit dem Auto zeigen sollte. Trotz meiner Bemühungen konnte ich Midjourney nicht dazu bringen, eine statische Gesamtansicht einer zweispurigen Autobahn zu generieren. Ich habe mich dann für ein lizenzfreies Bild von Unsplash entschieden.

Ich hatte gehofft, dass Runway mein Vertrauen in KI wieder stärken wird und, dass es dem Bild Leben eingehaucht werden wird. Ich nahm an, dass dies eine relativ einfache Aufgabe für die KI sein würde. Zu meiner Verwunderung, kämpfte die KI mit dem Konzept von Autos, die sich in entgegengesetzte Richtungen bewegen. Ich versuchte, die KI entsprechend zu instruieren: “Die Autos auf der rechten Seite des Bildes bewegen sich von der Kamera weg, und die Autos auf der linken Seite des Bildes bewegen sich auf die Kamera zu.” Ungeachtet meiner Bemühungen bewegten sich beide Gruppen von Autos entweder auf die Kamera zu oder von ihr weg, was zu dem surrealen Anblick von Autos führte, die sich auf einer Autobahn rückwärts bewegten.

Anders als bei den statischen Bildern, gibt es nicht viel Flexibilität bei der Nachbearbeitung der Videoausgabe von Runway, sobald sie generiert wurde. Im vorherigen Beispiel mit den Handdarstellungen von Midjourney ist es relativ einfach, die KI von Photoshop zu verwenden und die Fehler zu korrigieren.

Da die Videoausgabe jedoch keine HD-Qualität aufweist, wird die Korrektur deutlich schwieriger. Um beispielsweise ein Video mit einer Hand mit sieben Fingern zu bearbeiten, müsste man entweder die Hand in jedem Bild mühsam korrigieren und auf eine nahtlose Wiedergabe hoffen, oder sie durch eine statische Hand ersetzen und sie so weit wie möglich mit der Bewegung der ursprünglichen Komposition animieren und morphen.

Unabhängig von der gewählten Methode wäre dies immer noch mit einem erheblichen Aufwand verbunden, was dem ursprünglichen Zweck des Einsatzes von KI zur Vereinfachung meiner Arbeit widerspricht.

Zusammenfassung

Das Endergebnis ist passabel. Im Video sind unzählige Fehler und Unstimmigkeiten, die den künstlichen Ursprung verraten. Für Profis gehören diese Macken zum kreativen Prozess der KI. Sie verstehen die Grenzen, die Algorithmen und den mühsamen Aufwand, der erforderlich ist, um die Grenzen des Möglichen zu erweitern.

Für uneingeweihte Zuseher:innen, die zum ersten Mal über KI-generierte Inhalte stolpern, ist das jedoch eine ganz andere Geschichte. Wenn man sieht, wie Gesichter auf unerklärliche Weise nach der Hälfte des Videos ineinander verschmelzen oder Menschen plötzlich von den umgebenden Objekten verschluckt werden, stellt sich ein subtiles Unbehagen ein. Irgendetwas scheint einfach nicht zu stimmen.

Im Bereich der KI-generierten Inhalte befinden wir uns auf einer Gratwanderung zwischen bahnbrechender Innovation und rätselhafter Unvollkommenheit – ein schmaler Grat zwischen Kreativität und Verwirrung.

Bis auf Weiteres bleibt unsere Rolle als menschliche “KI-Driver” unerlässlich. Wir sind diejenigen, die durch dieses Labyrinth der Verwirrung navigieren und die Kreativität aus den algorithmischen Tiefen der KI herausholen müssen.

Eine Frage bleibt offen: Ist das Erstellen und Optimieren von Prompts mühsamer und fehleranfälliger als das Festhalten an traditionellen Methoden der Inhaltserstellung, wie z. B. die Verwendung von Archivbildern oder selbst erstellten Inhalten?

Die Facetten menschlicher Kommunikation sind umfangreich und komplex und stellen eine große Herausforderung für die Künstliche Intelligenz dar, die immer noch damit zu kämpfen hat, genau zu verstehen, was wir meinen, wenn wir nach etwas fragen. Folglich wiederholen wir oft Aufforderungen bis zum Gehtnichtmehr, mit geringen Wortänderungen, in der Hoffnung auf andere Ergebnisse, und so stehen wir oft ratlos da, wenn wir wieder mit bereits bekannten Ergebnissen konfrontiert werden.

Während die Künstliche Intelligenz ihre Fähigkeiten bei der Erstellung auffälliger statischer Bilder für Präsentationen oder Website-Heldenshots zur Schau stellt, steckt der Bereich, der von der KI erzeugten Videos noch in den Kinderschuhen – ein Bereich, dessen Potenzial noch nicht vollständig erforscht ist.

Wir helfen Ihnen dabei helfen, Ihre Effizienz mit intelligenten Designs und Technologien zu steigern.

Stay

tuned

Weitere Beiträge